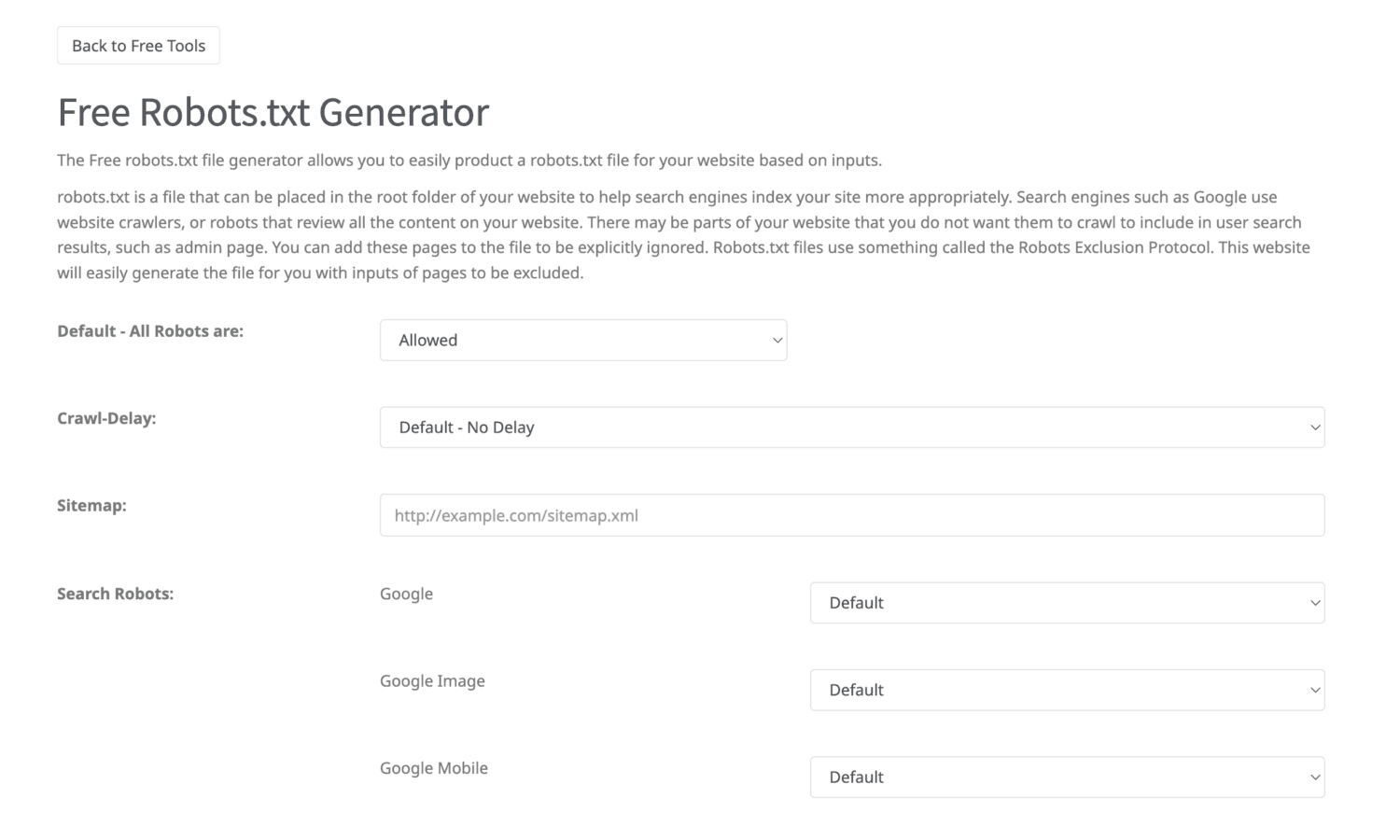

Wykorzystujemy go do tworzenia i dostosowywania plików robots.txt dla stron internetowych. Pozwala nam precyzyjnie kontrolować, jakie części witryn są indeksowane przez wyszukiwarki.

- Generowanie pliku robots.txt: Robots.txt Generator umożliwia nam szybkie tworzenie plików robots.txt. Wystarczy podać instrukcje dotyczące indeksowania poszczególnych części witryny, a narzędzie wygeneruje odpowiedni plik robots.txt.

- Dostosowywanie instrukcji dotyczących indeksowania: Narzędzie pozwala nam dostosowywać instrukcje dotyczące indeksowania poszczególnych stron, katalogów lub typów plików. Możemy określić, które części witryny mają być indeksowane, a które mają być wyłączone z indeksacji.

- Testowanie pliku robots.txt: Robots.txt Generator umożliwia również testowanie wygenerowanego pliku robots.txt, aby upewnić się, że wszystkie instrukcje są poprawne i zgodne z oczekiwaniami.

Robots.txt Generator to przydatne narzędzie, umożliwiającym kontrolę indeksacji naszych stron internetowych przez roboty wyszukiwarek. Dzięki niemu jesteśmy w stanie zapewnić, że strony, którymi się opiekujemy, są odpowiednio zindeksowane i spełniają wymagania strategii SEO.